Nel panorama mondiale lo sviluppo di Robot è cresciuto a dismisura negli ultimi anni, trainato da due fattori principali. Da un lato, molti nuovi prodotti prevedono il posizionamento così fine di alcune parti che per l’essere umano costituisce un problema, richiedendo molta concentrazione e un notevole sforzo mentale e fisico. Dall’altro, l’avvento di sistemi di sviluppo alla portata di tutti, soprattutto dei giovani, ha dato nuova linfa al settore della robotica generando una nuova tipologia di sperimentatori fai-da-te (i cosidetti “makers”) che oggigiorno sfornano idee e prototipi a cui molte industrie attingono per le proprie produzioni. Ad esempio ogni anno in molti paesi si svolge la Makers Faire, in Italia a Roma, dove vengono presentati sistemi robotici sempre più performanti.

Dal lato scientifico, le molte Università che si occupano di Robotica affrontano sia gli aspetti meramente meccanici, sia quelli elettronici e oggi, manco a dirlo, stanno accoppiando l’Intelligenza Artificiale alle macchine.

L’interazione fra umano e robot (la Human Robot Interaction, o HRI) è un argomento di estremo interesse che si sviluppa lungo la catena che parte dal progetto tecnico per arrivare addirittura alla psicologia e alla filosofia. Su questo ultimo aspetto, ad esempio, 40 anni fa nacque un grande dibattito su un argomento che allora muoveva i primi passi, la cosidetta “robotica antropomorfa” che postulava macchine in grado di sostituire completamente l’uomo. Il sogno (o l’incubo ?) era l’industria che funzionasse senza luci 24 ore al giorno, sfornando prodotti senza che alcun essere umano fosse presente nel capannone.

Oggi per fortuna la visione è cambiata e si tende a fabbricare Robot non per sostituire l’essere umano, ma per rendergli la vita più semplice facendosi carico di tutte le operazioni troppo oberanti e/o la cui precisione deve essere elevatissima. In questo scenario umani e Robot convivono all’interno dei medesimi spazi e quindi, volenti o nolenti, interagiscono. Si pensi ad esempio ai carrelli elevatori automatizzati in un deposito dove donne e uomini operano anch’essi: è evidente che se da un lato gli umani devono seguire regole per la propria incolumità, dall’altro i Robot devono essere equipaggiati con dispositivi di sicurezza per scongiurare guai.

Si è così sempre più sviluppato quel sottoinsieme della HRI che prende il nome di Physical Human Robot Interaction (PHRI) e che si focalizza sul rendere sicura l’interazione fra essere umano e macchina, soprattutto dotando i Robot di sensori e tecniche di rilevazione innovative. Infatti i moderni requisiti industriali richiedono che uno stesso Robot sia adattabile a diversi scenari che tengano conto della flessibilità e della ergonomicità della filiera produttiva. In questo scenario, l’utilizzo di videocamere come sensori risulta da un lato troppo dispendioso e dall’altro troppo complesso per l’elaborazione di un gran numero di immagini ad elevata risoluzione. Ciò ne rende impraticabile l’implementazione sui Robot.

Un recente lavoro di ricerca del Dipartimento di Informatica, Bioingegneria, Robotica e Ingegneria dei Sistemi (DIBRIS) dell’Università di Genova e dell’elbana Elbatech Srl (di cui chi scrive fa parte) ha effettuato un passo molto significativo verso sistemi robotici meglio integrati con l’essere umano (1). Due sono state le innovazioni principali:

- la realizzazione di reti compatte e interconnesse di sensori “tattili” in grado di fornire al Robot la capacità di rilevare une forza di contatto di un oggetto o di un umano;

- l’integrazione dei sensori tattili con stringhe di innovativi “sensori di prossimità” in grado di permettere al Robot di percepire la presenza di corpi e oggetti nelle vicinanze, prima dell’eventuale contatto fisico.

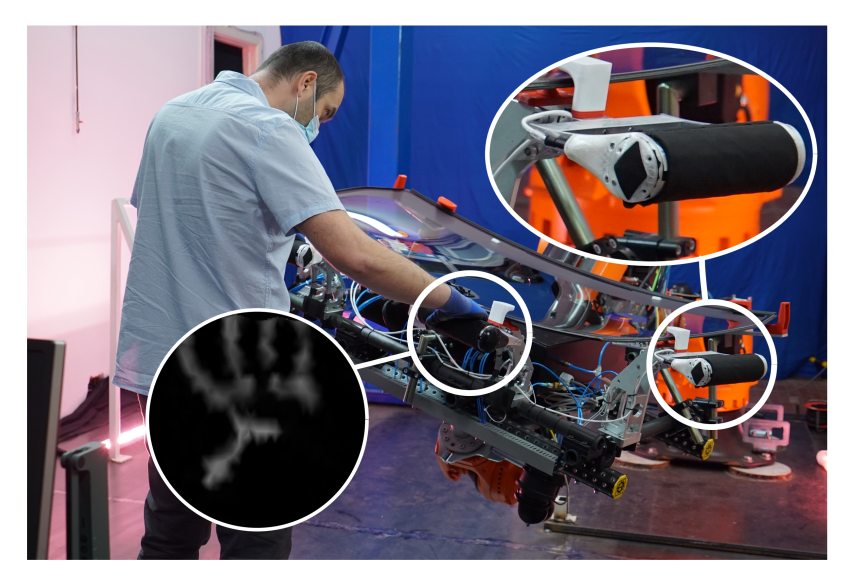

I sensori tattili sono stati progettati appositamente per offrire numerosi spot sensibili e sono basati su effetti capacitivi, un po’ come avviene negli interruttori “a sfioro” per accendere la luce di casa: in quel caso la presenza del dito provoca una variazione della carica elettrica fra due conduttori che viene misurata da un microcontroller dedicato allo scopo. Nel nostro caso uno di questi due conduttori è uno spot metallico sul circuito, mentre l’altro è un semplice strato di licra conduttiva che ricopre l’intera area occupata dai siti sensibili. La figura 1 mostra un Robot per il posizionamento di parti di automobile equipaggiato con una coppia di array di sensori tattili.

Figura 1. Robot con sensori tattili per il posizionamento di parabrezza “senza sforzo” da parte dell’operatore umano. Nel cerchio in basso a sinistra si vede la mappatura della mano così come percepita dal Robot, in cui è importante notare le zone a diversa intensità di segnale, che permettono al controller di prendere conseguenti decisioni e di movimentare il Robot opportunamente. Nell’ellisse in alto a destra si vede una seconda maniglia sensorizzata, in cui la zona nera è il panno di licra conduttiva descritto nel testo.

Tra gli altri particolari, nella figura 1 è visibile l’immagine del palmo della mano dell’operatore così come percepita dal Robot. Ciò non tragga in inganno, giacché si sta usando il termine “tattile”, che guarda caso rimanda proprio al senso del tatto che negli umani è proprio maggiormente espresso nelle mani. Infatti il sensore si definisce “tattile” nel verso diametralmente opposto, ciè dal punto di vista del Robot. La sua “mano” è il cilindro nero contenente decine di sensori tattili e solo incidentalmente l’oggetto toccato, in questo caso, è a sua volta la mano di un umano!

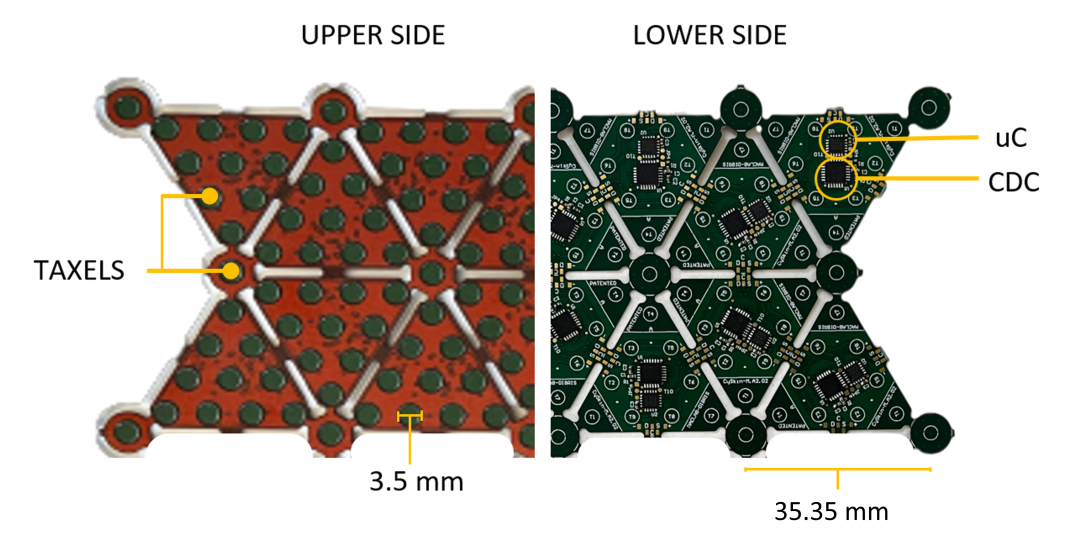

Si è deciso di formare triangoli di sensori con 10 spot ciascuno, si veda la figura 2. Ogni triangolo è connesso agli adiacenti con cui comunica per formare una rete fortemente interconnessa. Un foglio di triangoli è chiamato “patch” ed è costruito su un supporto flessibile in cui i singoli triangoli sono interconnessi da piccole piste, per cui la patch può essere comodamente curvata e adattata a superfici non piane, come ad esempio la parte cilindrica di un braccio Robot:

Figura 2. Parte di una patch di sensori tattili. A sinistra sono visibili gli spot sensibili e l’interconnessione tramite taxels. A destra la parte inferiore dei sensori stessi, con i componenti elettronici necessari, tra cui un microcontroller (uC) e un misuratore capacitivo (CDC).

Ma i soli sensori tattili non possono fornire un’interfaccia HRI all’avanguardia. Il fatto che lavorino in base alla forza/pressione di un corpo impone necessariamente che fra Robot e corpo avvenga un contatto. Ciò preclude tutta una serie di attività in cui è invece importante che il Robot si accorga della presenza di corpi nelle vicinanze e, possibilmente, li riconosca.

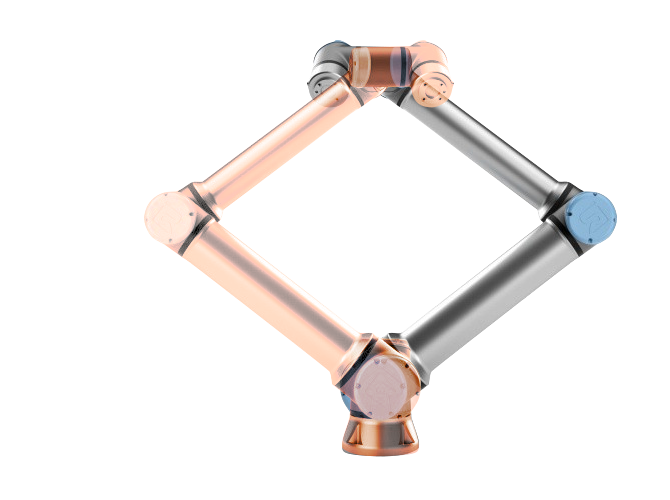

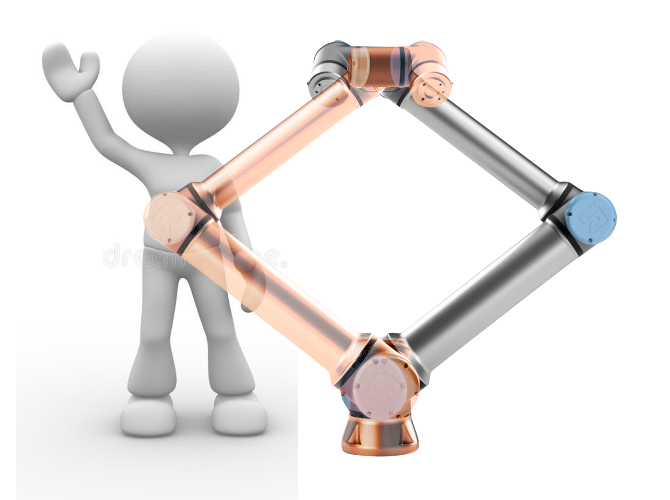

Si pensi ad esempio ad un braccio Robot programmato per ripere indefinitamente un certo movimento, ad esempio prendere un oggetto con la propria pinza, ruotare di 180 gradi e posare l’oggetto dall’altra parte. Ad oggi il braccio non può far altro che seguire pedissequamente le istruzioni con cui è stato programmato, anche se un ostacolo si frappone nel suo spazio di azione, come visibile il Figura 3:

Figura 3. A sinistra, un braccio Robot (grigio) effettua una rotazione di 180 gradi portandosi nella posizione opposta (color oro). A destra, se il braccio è privo di un sistema di riconoscimento ostacoli effettua l’operazione programmata incurante che nello spazio di azione si frapponga un ostacolo, in questo caso una persona.

Per ovviare al problema, precedenti studi (2) hanno cercato di integrare sul Robot dischi equipaggiati con sensori multi-modali magnetici e di prossimità. Tuttavia quella soluzione non è adattabile a Robot generici, bensì è applicabile ad un ben specifico tipo soltanto. Inoltre i sensori di prossimità utilizzati hanno un range di azione di soli 10 cm, il che non permette al Robot di avere una percezione reale del mondo che lo circonda.

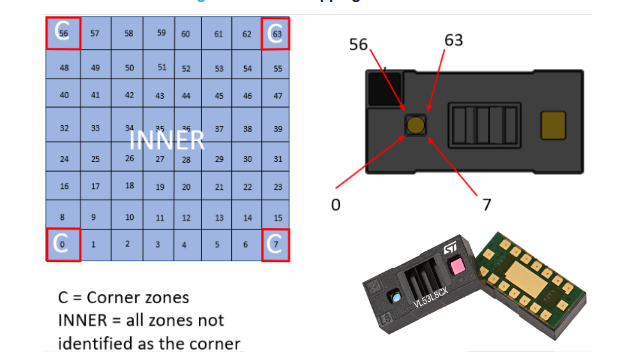

Noi abbiamo utilizzato sensori basati sul “tempo di volo” (Time-of-Flight o ToF sensors). Funzionano più o meno come l’orologio ottico di cui ho scritto recentemente su Elbareport parlando della dilatazione del tempo (https://www.elbareport.it/scienza-ambiente/item/68395-pillole-di-scienza-3-la-fantastica-scoperta-della-dilatazione-del-tempo): un emettitore laser invia impulsi di luce infrarossa che, se colpisce un oggetto o un corpo, viene riflessa e catturata da una matrice 8x8 di siti sensibili presenti sul dispositivo ToF. Si ottiene pertanto una piccola mappa di pixel che raccoglie l’informazione da ostacoli posti ad una distanza fino a 4 metri dall’emettitore, si veda la Figura 4:

Figura 4. Sensore Time-of-Flight utilizzato per costruire i bracciali del Robot. Sono visibili l’elemento emettitore di luce infrarossa (il rettangolino rossastro sotto la scritta ST) e la matrice di sensori ricevente il segnale riflesso (il cerchio azzurro sul lato opposto), costituito da una matrice 8x8 di siti sensibili.

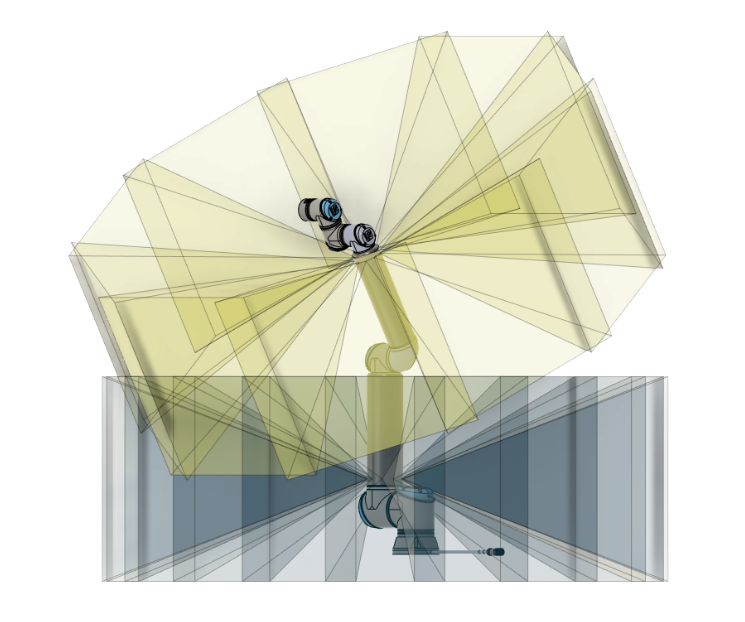

Abbiamo quindi organizzato una rete di ToF in grado di soddisfare l’esigenza di scansionare l’intero mondo circostante il Robot. Dato l’angolo di accettazione dei sensori, abbiamo deciso di predisporre “bracciali” con 10 ToF ciascuno e, nel caso di un braccio robot alto circa un metro, abbiamo stimato che due soli bracciali sono sufficienti per una panoramica completa, come mostra la simulazione al calcolatore fatta in fase di progetto, Figura 5:

Figura 5. Modello CAD (Computer Aided Design) di un braccio Robot modello UR10e con la proiezione del campo di visuale (Field-of-View) di due bracciali composti da 10 sensori ciascuno. Le parti più scure gialle e grigie mostrano una sovrapposizione dei fasci ottici che garantisce un buon margine di lavoro assicurando che l’intero spazio a 360 gradi è coperto.

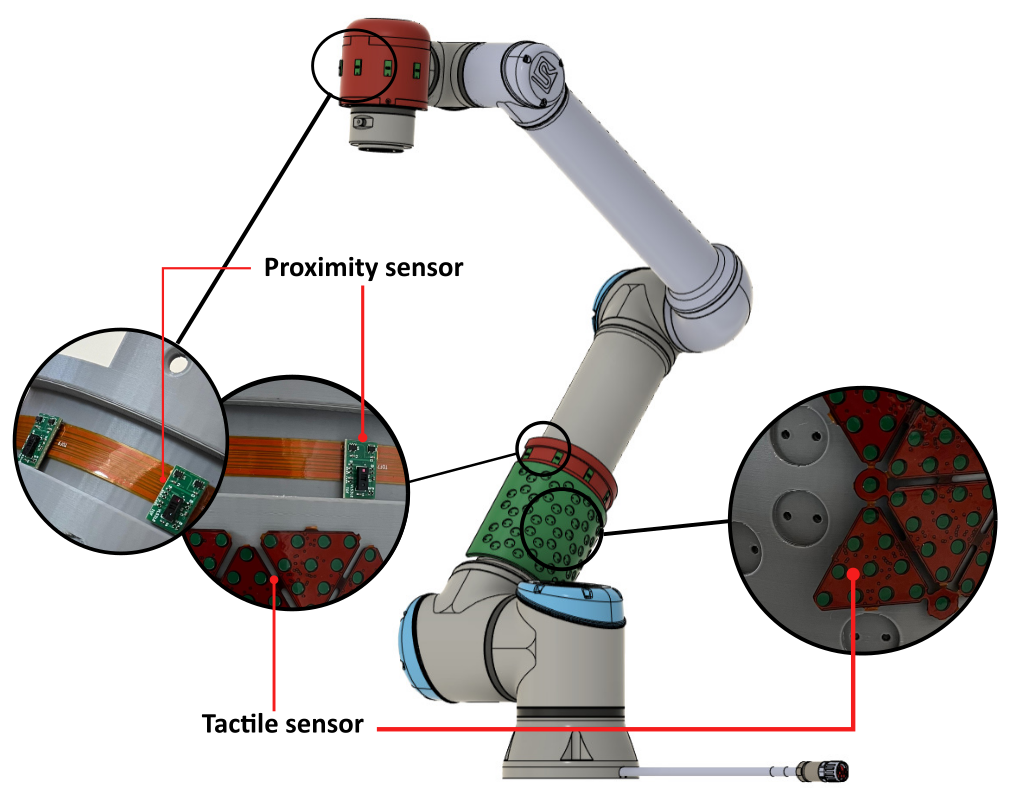

L’integrazione dei sensori tattili e di quelli di prossimità ha permesso la realizzazione di un braccio Robot completo e all’avanguardia, in grado di essere pilotato da programmi ma anche di prendere decisioni autonome in caso di rilevazione di ostacoli. Questa integrazione è stata molto impegnativa, a dimostrazione che spesso un concetto tutto sommato semplice necessita di notevoli sforzi ingegneristici per essere messo in pratica. Uno dei problemi principali è certamente l’integrità dei segnali elettrici lungo la complessa rete di sensori, poiché rumore elettrico, ambientale, termico costituiscono nemici dichiarati. Ma anche l’aver implementato soluzioni completamente digitali (e non analogiche) ha richiesto soluzioni avanzate per garantire che i flussi di segnale avvengano in tempi certi e noti.

La seguente Figura 6 mostra lo schema finale del braccio Robot che integra tutte le tipologie di sensori descritte:

Figura 6. Braccio robot con integrati patch di sensori tattili e ring di sensori di prossimità. I cerchi contengono le immagini reali di tali sensori così come risultano montati nei prototipi realizzati.

I test sul Robot hanno mostrato la piena affidabilità e robustezza del sistema realizzato, ma invece di annoiarvi con una serie di dati preferisco mostrarvi il video del test effettuato su alcune stringhe di sensori ToF. E siccome siamo gente di mare, non potevamo che provare il sistema nuotando. Nel video al link che segue l’insieme dei voxel bianchi (cioè dei pixel 3D) rappresenta altrettanti spot rilevati dai sensori che nel loro insieme formano la percezione che ha il Robot di cosa lo circonda. Come si può notare, i ToF non solo forniscono infomazione sulla presenza di un corpo, ma anche sulla sua dinamica, il che rende questa tecnologia particolarmente utile per sistemi di controllo veloci ed affidabili.

Questo il link: https://youtu.be/wls35aarBV4

Marco Sartore

(1) “From CySkin to ProxySKIN: Design, Implementation and Testing of a Multi-Modal Robotic Skin for Human–Robot Interaction”, Sensors, 2024, 24, 1334. https://doi.org/10.3390/s24041334

(2) “A Multi-Modal Sensor Array for Human–Robot Interaction and Confined Spaces Exploration Using Continuum Robots”, IEEE Sensors J. 2022, 22, 3585–3594.